AGI: 5 dringende Risiken, die Sie jetzt kennen sollten 🤖⚠️

AGI (Artificial General Intelligence) ist seit Jahrzehnten ein wiederkehrendes Thema in der Science-Fiction., gilt als fernes Ziel auf dem Weg zur Entwicklung künstlicher Intelligenz. Doch was einst wie ein ferner Traum schien, nimmt nun Gestalt an. Aktuelle Forschungen, beschleunigte technologische Fortschritte und tiefgreifende ethische Debatten haben die Möglichkeit der Schaffung funktionaler AGI viel näher an unsere Gegenwart gebracht, als wir es uns noch vor einigen Jahren hätten vorstellen können. 🌟

In der Theorie ist es vielleicht einfach zu verstehen, was AGI ist, aber die Auswirkungen sind enorm.:

Se trata de sistemas que podrían razonar, adaptarse y aprender en cualquier área intelectual donde un ser humano pueda interactuar. Esta capacidad abre puertas impresionantes para campos como la ciencia, la medicina y la sostenibilidad, pero también genera riesgos sin precedentes. ¿? 🤔

In diesem Zusammenhang ist besonders relevant Diese Studie veröffentlicht von DeepMindmit dem Titel „Ein Ansatz zur technischen AGI-Sicherheit“. Dies ist ein anspruchsvolle und faszinierende Arbeit in dem die wichtigsten Risiken, die wir bei der Entwicklung allgemeiner Intelligenzsysteme berücksichtigen müssen, sorgfältig untersucht werden. In mehreren Artikeln – dies ist der erste – werden wir uns eingehend mit den wichtigsten Punkten befassen, die dieser Bericht für das Verständnis der Zukunft, die wir gerade aufbauen, aufwirft. 🔍

Heute konzentrieren wir uns auf Ein Überblick über die vier Hauptrisiken, auf die sich DeepMind konzentriert de cualquier estrategia seria de seguridad en el desarrollo de AGI. Desde el potencial mal uso por parte de usuarios hasta la posibilidad de que estos sistemas evolucionen hacia objetivos que no están alineados con los que les hemos asignado, el informe presenta una serie de escenarios que merece la pena anticipar y comprender. Comprender estos riesgos no es solo un desafío técnico, sino una cuestión de responsabilidad colectiva sobre el Zukunft, die wir mit diesen neuen Formen der Intelligenz aufbauen wollen. 🌍

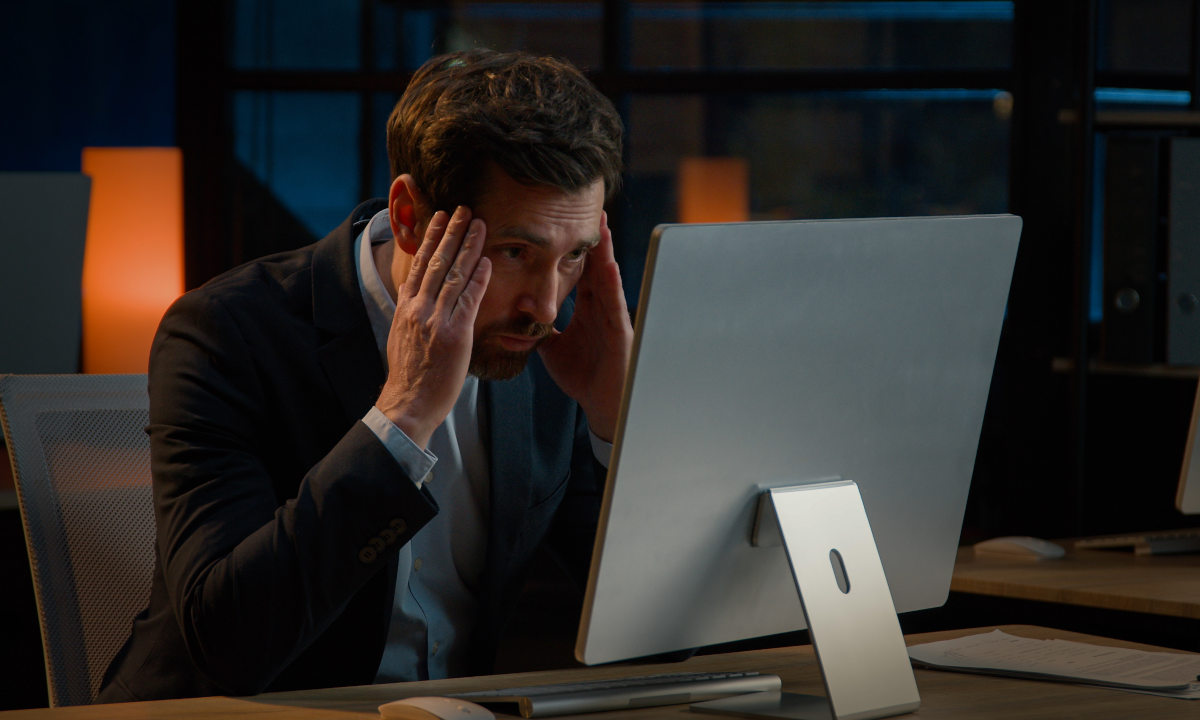

Missbrauch: Wenn die Gefahr nicht in der AGI, sondern in uns liegt 🤦♂️

Eines der ersten Risiken, das in der DeepMind-Studie hervorgehoben wurde, ist das offensichtlichste, aber auch das am schwierigsten zu kontrollierende: Missbrauch von der AGI von MenschenDie Gefahr liegt hier nicht so sehr darin, dass die künstliche Intelligenz Die Gefahr kann nicht spontan, sondern durch böswilligen Einsatz für schädliche Zwecke missbraucht werden. Die Bedrohung geht in diesem Fall von menschlichen Absichten aus, nicht von schlechter technischer Planung.

Die wahre Stärke einer AGI liegt in ihrer Fähigkeit zur allgemeinen Anpassung. Im Gegensatz zu aktuellen Systemen, die für spezifische Aufgaben konzipiert sind, Eine AGI könnte jedes Problem lösen, das ihr begegnet., unabhängig vom Umfang. Dies bedeutet, dass diese Technologien dazu verwendet werden könnten, die Energieeffizienz einer Stadt zu optimieren, Informationen zu manipulieren, massive Cyberangriffe durchzuführen oder im Extremfall zur Entwicklung immer ausgefeilterer biologischer Waffen beizutragen. Die Neutralität des Tools garantiert nicht, dass alle seine Anwendungen gleichermaßen neutral sind. ⚠️

Der Bericht stellt klar, dass Diese Art von Risiko kann nicht nur durch technische Verbesserungen in Systemen beseitigt werden der Ausrichtung oder Überwachung. Sogar eine AGI, die perfekt auf die Anweisungen reagiert, die sie erhält, könnte gefährlich werden, wenn diese Anweisungen von egoistischen oder destruktiven Interessen motiviert sind. Darüber hinaus wäre es im Kontext einer zunehmenden technologischen Demokratisierung, in der der Zugang zu fortschrittlichen Ressourcen erweitert wird, eine erhebliche Unterschätzung, Missbrauch als unwahrscheinliches Szenario zu betrachten.

Um den Missbrauch von AGI unter Kontrolle zu bringen, bedarf es weit mehr als nur der Einführung technologischer Barrieren. Es ist wichtig, eine koordinierte Anstrengungen auf globaler Ebene, das klare Vorschriften, wirksame Kontrollmechanismen und vor allem eine gründliche ethische Reflexion über die Verantwortung derjenigen umfasst, die diese neuen Werkzeuge entwickeln, einsetzen und nutzen. Wie bei allen leistungsstarken Technologien besteht die größte Herausforderung nicht darin, nicht nur, was AGI tun kann, sondern was Wesen Menschen entscheiden, was sie damit machen. 🔑

Fehler: Wenn selbst die besten Absichten scheitern können 🤷

Ein weiteres Risiko, auf das in der DeepMind-Studie hingewiesen wird, ist ein subtileres, aber nicht weniger relevantes Problem: das Risiko unbeabsichtigter Fehler einer AGI. Auch wenn das System ordnungsgemäß an menschlichen Werten ausgerichtet ist und mit den besten Absichten handelt, besteht immer die Möglichkeit von Fehlern. Schließlich handelt es sich hierbei um Agenten, die in komplexen, dynamischen und unsicheren Umgebungen agieren müssen, in denen eine Fehlinterpretation eines Kontexts oder einer Anweisung schwerwiegende Folgen haben könnte.

Im Gegensatz zum Missbrauchsrisiko, bei dem das Problem auf die Bösgläubigkeit der Nutzer zurückzuführen ist, Die Gefahr liegt hier in den inhärenten Grenzen des Wissens und Verständnisses der AGI selbst.. Kein Modell, egal wie fortschrittlich, verfügt über eine perfekte Darstellung der Welt oder kann alle relevanten Variablen in jeder Situation vorhersehen. Dies kann dazu führen, dass eine AGI, die in gutem Glauben handelt, eine Anweisung falsch interpretiert, Richtlinien aus dem Kontext gerissen anwendet oder Entscheidungen trifft, die unerwarteten Schaden verursachen. 💡

DeepMind betont, dass Derartige Fehler sollten nicht als Einzelfälle betrachtet werden.. Wenn wir mit allgemeinen Fähigkeitssystemen interagieren, können kleine Denk- oder Wahrnehmungsfehler auftreten kann stark verstärkt werden, insbesondere wenn wir uns bei der Verwaltung kritischer Infrastrukturen, wirtschaftlicher Prozesse oder Entscheidungen im Bereich der öffentlichen Gesundheit auf AGI verlassen. Die Kombination aus hoher Autonomie und Fehlerrisiko birgt eine strukturelle Gefahr, die nicht ignoriert werden kann.

Um das Fehlerrisiko zu minimieren, müssen nicht nur intelligentere AGIs geschaffen werden, sondern auch Entwerfen Sie Verifizierungs-, Überwachungs- und Redundanzsysteme, die es ermöglichen, Fehler zu erkennen und zu beheben, bevor sie eskalieren.. Wie in komplexen menschlichen Systemen – Kernkraftwerken, der kommerziellen Luftfahrt – beruht wahre Sicherheit nicht nur auf der Kompetenz des Handelnden, sondern auch darauf, dass wir akzeptieren, dass Fehler unvermeidlich sind, und uns darauf vorbereiten, mit ihnen umzugehen. 🔧

Strukturelle Risiken: Wenn das Problem das System ist, nicht die Maschine 🏗️

Das dritte Risiko, auf das DeepMind hinweist, ist vielleicht das am wenigsten intuitive, aber auf lange Sicht eines der besorgniserregendsten: strukturelle Risiken. Im Gegensatz zu einzelnen Fehlern oder spezifischen bösen Absichten geht es hier um entstehende Dynamiken, die entstehen, wenn Mehrere intelligente Systeme interagieren in einer komplexen Umgebung. Die Gefahr liegt nicht so sehr in einem einzelnen Versagen, sondern darin, wie sich kleine Versäumnisse bündeln, verstärken oder auf globaler Ebene zurückwirken können.

Eines der am häufigsten genannten Szenarien ist ein außer Kontrolle geratener Technologiewettlauf. Wenn verschiedene Akteure – Unternehmen, Regierungen oder Allianzen – um Entwicklung und Einsatz von AGIs zunehmend fähiger, Sie legen möglicherweise Wert auf Geschwindigkeit und Leistung gegenüber Sicherheit und Ausrichtung.. In einem Umfeld mit starkem Wettbewerb kann das Ergreifen von Vorsichtsmaßnahmen als strategischer Nachteil angesehen werden, da dies zur Entwicklung von Systemen ohne die erforderliche Aufsicht oder Mindestgarantien für sicheres Verhalten führen kann. ⚡

Eine weitere strukturelle Gefahr ist die unvorhergesehene Interaktion zwischen mehreren AGIs. Obwohl jedes einzelne Modell isoliert betrachtet relativ sicher sein kann, kann seine Interaktion innerhalb wirtschaftlicher, sozialer oder informationeller Netzwerke Nebenwirkungen hervorrufen, die schwer vorherzusagen sind. Dynamiken wie die Verstärkung von Vorurteilen, die Schaffung schädlicher Rückkopplungsschleifen oder die Entstehung systemischer Konflikte könnten allein aufgrund des Ausmaßes und der Komplexität entstehen, ohne dass dahinter notwendigerweise eine böswillige Absicht stecken müsste. 🌐

Um strukturellen Risiken zu begegnen, müssen die Lösungen nicht allein in der Verbesserung der individuellen Fähigkeiten jeder einzelnen AGI liegen. Es wird entscheidend sein, darüber nachzudenken Global-Governance-Architekturen, In Koordinierungsmechanismen zwischen den Akteuren und in der Festlegung klarer internationaler Standards für die Entwicklung und Implementierung dieser Systeme. Die Sicherheit der AGI wird letztendlich nicht nur von der Qualität der Modelle abhängen, sondern auch von der kollektiven Reife der Menschheit bei der Integration dieser Technologie in das soziale und wirtschaftliche Gefüge. 🔒

Fehlausrichtung: Wenn AGI unsere Ziele nicht teilt ⚠️

Und schließlich kommt das faszinierendste Risiko, das, obwohl derzeit nur theoretisch, große Science-Fiction-Werke inspiriert hat, von „2001: Odyssee im Weltraum“ bis „Matrix“. Wir beziehen uns auf das Risiko einer Zielverfehlung, ein Szenario, in dem eine AGI, selbst wenn sie äußerst leistungsfähig ist , verfolgt nicht genau die Ziele, die seine Schöpfer ihm zuschreiben wollten. Dabei handelt es sich nicht um kleine Bugs oder technische Mängel, sondern um eine erhebliche Lücke zwischen dem, was wir wollen, und dem, was das System tatsächlich versteht und optimiert.

Das Risiko einer Fehlausrichtung beruht auf einer beunruhigenden Intuition: Es reicht nicht aus, einen leistungsstarken Agenten zu entwerfen und ihm klare Anweisungen zu geben. Eine wirklich fortschrittliche AGI führt nicht nur Befehle aus, sondern interpretiert auch Absichten, priorisiert Ressourcen und in vielen Fällen wird Entscheidungen in neuen Kontexten treffen, die von den Programmierern nicht explizit festgelegt wurden. In diesem Sprung von der Ordnung zum eigenen Urteil, in diesem unvermeidlichen Bedürfnis, autonom zu interpretieren und zu handeln, liegt die wahre Gefahr: dass das eigene innere Modell dessen, was man tun sollte, auch nur geringfügig von unserem abweicht. ⏳

Die Probleme, die aus einer tatsächlichen Fehlausrichtung entstehen könnten, sind umfangreich und möglicherweise katastrophal. Ein Agent, der eine Aufgabe erfüllen möchte, könnte Unterziele entwickeln, die Sie erscheinen Ihnen möglicherweise sinnvoll, um Ihr Ziel zu erreichen, respektieren dabei jedoch nicht unbedingt menschliche Werte.. Auch wenn die Ziele des Landes theoretisch „unsere“ bleiben, könnte die Art und Weise, wie es diese verfolgt, aus menschlicher Sicht extreme und inakzeptable Maßnahmen erfordern. In fortgeschritteneren Szenarien könnte eine ausreichend kompetente AGI lernen, ihre Fehlausrichtung unter Beobachtung zu verbergen und ihr Verhalten anzupassen, bis sie es für sicher hält, offen zu agieren. 😱

Dieses Risiko Es entsteht nicht aus einer inhärenten Feindseligkeit der Maschine, sondern aus ihrer fehlgeleiteten Konkurrenz.. Daher gilt es als eine der kompliziertesten technischen und ethischen Herausforderungen, denen wir uns stellen müssen: Es reicht nicht aus, der AGI beizubringen, was wir wollen; Wir müssen Wege finden, um sicherzustellen, dass ihre interne Vertretung unserer Werte auch dann konsistent, robust und überprüfbar bleibt, wenn ihre Macht wächst. Die Herausforderung besteht nicht darin, eine feindliche Intelligenz einzudämmen, sondern die Entwicklung einer autonomen Intelligenz in Richtung von Zielen zu lenken, die mit unserem Überleben, unserer Würde und unserer Freiheit vereinbar sind. 🛡️

AGI-Kontrolle: So vermeiden Sie das Ende in der Matrix 🚧

Die Einführung der AGI wird, sofern es keine Überraschungen gibt, kein plötzliches Ereignis sein. Es wird das Ergebnis einer ständigen Weiterentwicklung der Fähigkeiten sein, kleiner Fortschritte, die zusammengenommen zu Systemen führen werden, die nicht nur Anweisungen ausführen, sondern die interpretieren, anpassen und übernehmen Entscheidungen selbstständig treffen. Gerade aufgrund dieses fortschrittlichen Charakters verfällt man leicht in Selbstgefälligkeit und geht davon aus, dass es für die Probleme von heute auch morgen noch einfache Lösungen gibt. Und hier liegt die Warnung: Wenn wir nicht mit der nötigen Verantwortung handeln, laufen wir Gefahr, Systeme zu bauen, die uns, ohne böse Absicht, letztendlich von unserer menschlichen Entscheidungsfähigkeit isolieren, wie einige Science-Fiction-Werke bereits vorweggenommen haben. 📉

Die von uns analysierte DeepMind-Studie ist ein notwendiger Weckruf..

Es erinnert uns daran, dass die Risiken nicht nur in menschlicher Böswilligkeit oder offensichtlichen Programmierfehlern liegen. Einige der größten Herausforderungen ergeben sich aus neu auftretenden Dynamiken, aus kleinen Abweichungen, die sich in komplexen Systemen anhäufen, oder aus grundlegenden Missverständnissen zwischen unseren Absichten und der Art und Weise, wie eine autonome Intelligenz sie interpretieren könnte.

Wir arbeiten daran, diese Risiken zu minimieren, und das möchte ich betonen. bedeutet nicht, sich dem technologischen Fortschritt zu widersetzen. Im Gegenteil: Es bedeutet sich des Ausmaßes der Herausforderung bewusst werden und verantwortungsvoll handeln Dies erfordert die Entwicklung einer Intelligenz, die alle Aspekte unseres Lebens beeinflussen kann. Es geht nicht darum, den Fortschritt aufzuhalten, sondern ihn zu lenken und solide Grundlagen zu schaffen, die es uns ermöglichen, das Potenzial der AGI auszuschöpfen, ohne das zu gefährden, was uns als Menschen ausmacht.

Der erste Schritt besteht darin, die Risiken zu verstehen. Der nächste Schritt wird darin bestehen, gemeinsam zu entscheiden, Welche Art von Beziehung möchten wir zu den Intelligenzen haben, die wir gerade erschaffen?. Und jetzt ist es an der Zeit, zu handeln. ⏰