Spicychat-KI vs. Charakter-KI: Wer gewinnt im Jahr 2025? 🤖🔥

Vergleichen Sie Spicychat-KI und Charakter-KI! Entdecken Sie Funktionen, Preise und Anwendungsfälle für interaktive Gespräche, Storytelling und KI-Charaktererstellung. 🤖💬

Spicychat AI vs. Character AI Übersicht: Detaillierter Vergleich mit Funktionen und Preisen

Spicychat AI y Character AI son dos plataformas líderes para crear experiencias de chat interactivas potenciado por IA. Ambas herramientas ofrecen características únicas adaptadas para una comunicación personalizada, pero se dirigen a diferentes casos de uso. Mientras Spicychat AI resalta capacidades de conversación en tiempo real, Character AI se centra en la construcción de personajes detallados y narración de historias. Esta comparación examina sus características, precios y usuarios ideales. 🌟

Funktionsvergleich: Spicychat-KI vs. Charakter-KI

- Spicychat-KI

- Echtzeit-Gespräche: Bietet schnelle, dynamische Antworten im Chat.

- Benutzerzentrierte Personalisierung: Ermöglicht umfassende Anpassungen für den persönlichen und kommerziellen Gebrauch.

- Mehrsprachige Unterstützung: Erleichtert die globale Kommunikation mit einer Vielzahl von Sprachoptionen.

- API-Integration: Nahtlose Integration mit externen Anwendungen.

- Charakter-KI

- Charakterbildung: Erstellen Sie KI-Personas mit bestimmten Eigenschaften und Hintergründen.

- Verbessertes Storytelling: Maßgeschneidert für immersives Rollenspiel und narratives Erstellen.

- Vortrainierte Charaktere: Greifen Sie auf eine Bibliothek vorgefertigter Charaktere zur schnellen Verwendung zu.

- Teilen in der Community: Teilen und erkunden Sie benutzergenerierte Charaktere und Inhalte.

Preisvergleich

- Spicychat-KI: Bietet eine Abonnementmodell gestaffelt ab $10/Monat für Basisbenutzer und $50/Monat für erweiterten API-Zugriff.

- Charakter-KI: Kostenlos mit eingeschränkten Funktionen, mit Premium-Plänen ab $20/Monat für erweiterte Anpassung und schnellere Reaktionszeiten.

Welche Plattform ist die richtige für Sie?

- Wählen Sie Spicychat AI Wenn Sie eine schnelle und interaktive KI benötigen für Echtzeitanwendungen, wie Support gegenüber dem Kunden oder sozialem Engagement. 💼

- Wähle die Charakter-KI egal, ob Sie sich auf das Geschichtenerzählen, Rollenspiele oder die detaillierte Erstellung von KI-Charakteren konzentrieren. 🎭

Im Kampf zwischen Spicychat AI und Character AI haben wir wichtige Aspekte wie Upvotes, Funktionen, Bewertungen, Preise und Alternativen analysiert, um zu bestimmen, welches KI-Tool die Nase vorn hat. 🏆

In den letzten Jahren haben KI-Chatbots die Art und Weise, wie wir mit Technologie interagieren, revolutioniert. Zwei prominente Namen auf diesem Gebiet sind Spicychat AI und Character AI. Als KI-Technologie-Enthusiast hatte ich die Gelegenheit, beides ausgiebig zu nutzen. In diesem Artikel werde ich meine persönlichen Erfahrungen und Kenntnisse teilen und vergleichen Spicychat-KI und Charakter-KI, um Ihnen bei der Entscheidung zu helfen, welche Option für Ihre Anforderungen am besten geeignet ist. 📊

Spicychat AI Übersicht

Bei der Überprüfung von Spicychat AI und Charakter-KIist klar, dass jede Plattform unterschiedliche Vorteile bietet und sich an unterschiedliche Benutzerpräferenzen anpasst. Hier ist eine Zusammenfassung meines detaillierten Vergleichs:

Spicychat AI ist darauf ausgelegt, dynamische und spannende Gespräche zu ermöglichen. Es ist für seine Fähigkeit bekannt, ein breites Themenspektrum zu bewältigen, was es zu einem vielseitigen Werkzeug sowohl für den gelegentlichen als auch für den professionellen Gebrauch macht. Basierend auf meinen Recherchen und persönlichen Erfahrungen ist die KI von Spicychat besonders gut darin, menschenähnliche Antworten zu generieren, die sich an unterschiedliche Gesprächskontexte anpassen können.

Features und Funktionen

Spicychat AI bietet mehrere bemerkenswerte Funktionen:

- Natürliche Sprachverarbeitung (NLP): Hervorragend im Verstehen und Generieren menschenähnlicher Text.

- Umgang mit mehreren Themen: Verwalten Sie effizient eine Vielzahl von Themen in einem einzigen Gespräch.

- Benutzerfreundliche Oberfläche: Einfache Navigation und klares Design verbessern das Benutzererlebnis.

Hier ist eine Zusammenfassung meines detaillierten Vergleichs in Tabellenform:

| Funktion/Aussehen | Spicychat-KI | Charakter-KI |

|---|---|---|

| Gesprächsqualität | Starke Konversationsfähigkeiten, behält Kontext und Relevanz bei. | Persönlichkeitsbasierte, personalisierte und ansprechende Interaktionen. |

| Personalisierung | Begrenzte Anpassungsoptionen, im Allgemeinen anpassbar. | Hoher Grad an Anpassung, der die Auswahl oder Gestaltung spezifischer Bot-Persönlichkeiten ermöglicht. |

| Benutzerfreundlichkeit | Benutzerfreundliche Benutzeroberfläche, einfache Navigation. | Schnelle Reaktionszeiten und geringe Ausfallzeiten. |

| Anwendungen im realen Leben | – Lässige Gespräche – Professionelle Nutzung – Lernwerkzeug | – Rollenspiele – Kreatives Schreiben - Unterhaltung |

| Leistung | Im Allgemeinen zuverlässig, jedoch mit gelegentlichen Verzögerungen aufgrund der Persönlichkeitsverarbeitung. | Im Allgemeinen zuverlässig, jedoch mit gelegentlichen Verzögerungen aufgrund der Persönlichkeitsverarbeitung. |

| Technischer Support und Updates | Regelmäßige Updates, agiler Support. | Häufige Updates, unterstützende Community, kleinere Anpassungsprobleme. |

| Preise und Erreichbarkeit | Kostenlose Version mit grundlegenden Funktionen, Premium-Optionen für erweiterte Funktionen. | Ähnliches Preismodell, Premium-Optionen für umfassende Anpassungen. |

| Kostenlose Funktionen vs. Premium | Kostenlose Version verfügbar, Premium bietet erweitertes NLP und zusätzliche Funktionen. | Solide kostenlose Version, Premium schaltet umfangreiche Anpassungsmöglichkeiten und anspruchsvolle Persönlichkeitsmerkmale frei. |

Letztendlich ist Spicychat AI für diejenigen zu empfehlen, die einen vielseitigen und zuverlässigen Chatbot für den allgemeinen Gebrauch bevorzugen, während Charakter-KI Es ist ideal für Benutzer, die personalisierte und immersive Interaktionen genießen. Die Wahl hängt von individuellen Bedürfnissen und Vorlieben ab. 🌐

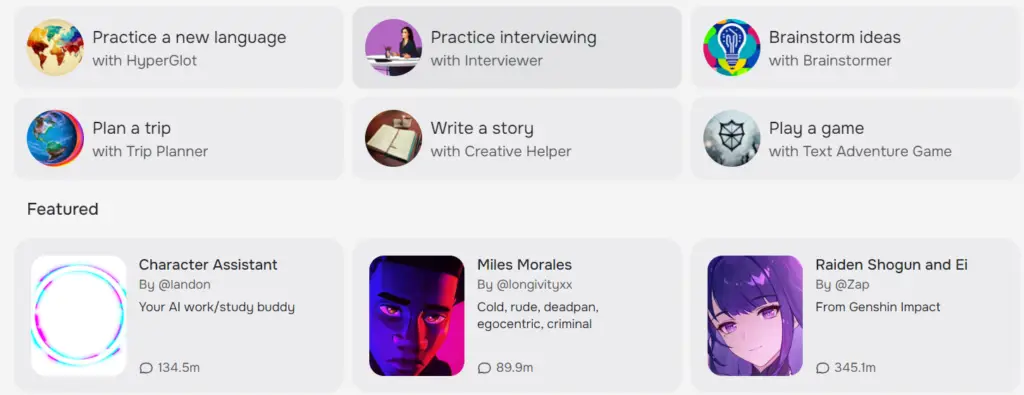

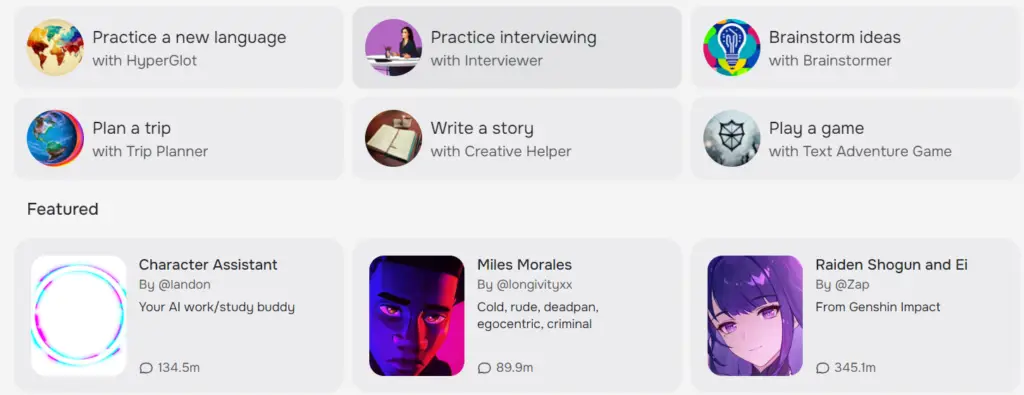

Charakter-KI-Übersicht

Character AI hingegen konzentriert sich auf die Schaffung ausgeprägter Persönlichkeiten für seine Chatbots. Jeder Bot ist so konzipiert, dass er einzigartige Merkmale und Verhaltensweisen aufweist und den Benutzern ein intensiveres und personalisierteres Erlebnis bietet. Meine Interaktionen mit Character AI haben gezeigt, dass es die Stärke hat, Gespräche authentisch und auf die entworfene Persönlichkeit des Bots zugeschnitten erscheinen zu lassen. 🎨

Features und Funktionen

Charakter-KI zeichnet sich durch Folgendes aus:

- Anpassbare Persönlichkeiten: Benutzer können vorgefertigte Bot-Persönlichkeiten entwerfen oder auswählen.

- Ansprechende Interaktionen: Gespräche fühlen sich authentischer und persönlicher an.

- Erweiterte Anpassungsoptionen: Benutzer können die Antworten des Bots anpassen, um sie besser an die gewünschten Eigenschaften anzupassen.

Vergleich der Hauptfunktionen

Gesprächsqualität

- Spicychat-KI: Er verfügt über umfassende Konversationsfähigkeiten und ist geschickt darin, den Kontext beizubehalten und relevante Antworten zu geben.

- Charakter-KI: Hervorragend geeignet für persönlichkeitsbasierte Interaktionen, wodurch Gespräche persönlicher und spannender werden.

Personalisierung

- Spicychat-KI: Begrenzte Anpassungsoptionen, der Schwerpunkt liegt eher auf der allgemeinen Anpassbarkeit.

- Charakter-KI: Hoher Grad an Anpassung, sodass Benutzer bestimmte Bot-Persönlichkeiten auswählen oder entwerfen können.

Benutzerfreundlichkeit

- Spicychat-KI: Benutzerfreundliche Benutzeroberfläche mit klarer Navigation.

- Charakter-KI: Aufgrund der Anpassungsmöglichkeiten etwas komplexer, aber mit ein wenig Einarbeitung dennoch zugänglich. 📚

Benutzererfahrung mit Spicychat AI

Aus meiner persönlichen Erfahrung heraus beeindruckt Spicychat AI durch seine Fähigkeit, eine große Bandbreite an Anfragen zu verstehen und darauf zu antworten. Egal, ob Sie nach dem Wetter fragten, Ratschläge suchten oder einfach nur chatten wollten, die KI von Spicychat lieferte stets schlüssige und relevante Antworten. Die Benutzeroberfläche ist intuitiv, sodass Sie Gespräche problemlos beginnen und fortsetzen können, ohne dass Sie sich erst anstrengen müssen. 🌈

Anwendungen im realen Leben

- Lässige Gespräche: Ideal für alltägliche Chats und allgemeine Anfragen.

- Professioneller Einsatz: Nützlich für den schnellen Informationsabruf und professionelle Interaktionen.

- Lerntool: Es kann beim Erlernen neuer Themen durch spannende Dialoge helfen.

Benutzererfahrung mit Charakter-KI

Die Verwendung der Charakter-KI war eine andere, aber ebenso lohnende Erfahrung. Der Personalisierungsaspekt ermöglichte mir die Interaktion mit Chatbots, die sich einzigartig auf meine Vorlieben zugeschnitten anfühlten. Sie könnten beispielsweise einen Bot auswählen, der humorvoll, ernst oder sogar von fiktiven Charakteren inspiriert ist. Durch diesen Grad an Anpassung wurden die Interaktionen spannender und unterhaltsamer, auch wenn die anfängliche Einrichtung etwas mehr Aufwand erforderte. 🌟

Anwendungen im realen Leben

- Rollenspiele: Hervorragend für immersive Rollenspielerlebnisse.

- Kreatives Schreiben: Nützlich zum Entwickeln von Ideen und Charakterdialogen.

- Unterhaltung: Bietet ansprechende und abwechslungsreiche Interaktionen zu Unterhaltungszwecken. 🎉

Leistung und Zuverlässigkeit

In Bezug auf die Leistung sind sowohl Spicychat AI als auch Character AI zuverlässig, es gibt jedoch einige Unterschiede:

- Spicychat-KI: Schnelle Reaktionszeiten und minimale Ausfallzeiten machen es zu einer zuverlässigen Wahl für den Dauereinsatz.

- Charakter-KI: Im Allgemeinen zuverlässig, es wurden jedoch gelegentlich Verzögerungen festgestellt, wahrscheinlich aufgrund der zusätzlichen Verarbeitung, die für persönlichkeitsgesteuerte Antworten erforderlich ist.

Technischer Support und Updates

- Spicychat-KI: Regelmäßige Updates und reaktionsschneller technischer Support verbessern das Benutzererlebnis.

- Charakter-KI: Häufige Updates und eine unterstützende Community, obwohl Anpassungsfunktionen manchmal zu kleineren Fehlern führen können.

Preise und Erreichbarkeit

- Spicychat-KI: Bietet eine kostenlose Version mit grundlegenden Funktionen sowie Premium-Optionen für erweiterte Funktionen. Dadurch können die meisten Benutzer es ausprobieren, bevor sie ein Abonnement abschließen.

- Charakter-KI: Ähnliches Preismodell mit einer kostenlosen Version und Premium-Optionen. Die zusätzlichen Anpassungsfunktionen der Premium-Option können die Kosten für Benutzer rechtfertigen, die ein persönlicheres Erlebnis wünschen.

Kostenlose Funktionen vs. Premium

- Spicychat-KIDie kostenlose Version ist recht leistungsfähig, aber die Premiumversion bietet erweitertes NLP und zusätzliche Funktionen.

- Charakter-KI: Die kostenlose Version bietet ein solides Erlebnis, aber die Premiumversion schaltet umfangreiche Anpassungsmöglichkeiten und anspruchsvollere Persönlichkeitsmerkmale frei.

Positive Stimmen

- SpicyChat KI: Bekannt für seine breite Konversationsfähigkeiten und benutzerfreundliches Design erhält oft positives Feedback.

- Charakter-KI: Gelobt für ihre hochgradig anpassbaren Persönlichkeiten und ansprechenden Interaktionen.

Eigenschaften

- SpicyChat KI: Vielseitig im Umgang mit mehreren Themen, natürliche Sprachverarbeitung, intuitive Benutzeroberfläche.

- Charakter-KI: Anpassbare Persönlichkeiten, ansprechende und personalisierte Gespräche, erweiterte Anpassungsoptionen.

Bewertungen

- SpicyChat KI: Benutzer schätzen seine Zuverlässigkeit und Anpassungsfähigkeit.

- Charakter-KI: Benutzer lieben das Erlebnis immersiver und personalisierter Interaktionen.

Preise

- SpicyChat KI: Es ist eine kostenlose Version mit Premium-Optionen für erweiterte Funktionen verfügbar.

- Charakter-KI: Ähnliches Preismodell, Premiumfunktionen ermöglichen umfangreiche Anpassungen.

Alternativen

Für beide Tools gibt es Alternativen, die Wahl hängt jedoch hauptsächlich von der Präferenz des Benutzers für Vielseitigkeit (SpicyChat AI) oder personalisierte Interaktion (Character AI) ab. 🤔

Abschließende Überlegungen und Empfehlungen

Zusammenfassend lässt sich sagen, dass sowohl die Spicychat-KI als auch die Charakter-KI ihre einzigartigen Stärken haben. Spicychat AI ist ideal für Benutzer, die einen vielseitigen und zuverlässigen Chatbot suchen, der sich durch hervorragende allgemeine Konversationen auszeichnet. Andererseits ist Character AI ideal für diejenigen, die personalisierte Interaktionen mögen und bereit sind, etwas mehr Zeit in die Konfiguration der Persönlichkeiten ihres bevorzugten Bots zu investieren.

Wenn Sie einfache, zuverlässige und anpassbare Gespräche bevorzugen, ist Spicychat AI erfahrungsgemäß eine gute Wahl. Wenn Sie jedoch eine intensivere und persönlichere Interaktion wünschen, ist Character AI möglicherweise die bessere Option. Letztendlich hängt die Wahl von Ihren spezifischen Bedürfnissen und Vorlieben ab. ✨