OpenAI 보고서: 중국과 이란 해커, 맬웨어 및 피싱에 ChatGPT 사용

중국과 이란 해커는 ChatGPT 및 LLM 도구를 사용하여 맬웨어 및 피싱 공격을 개발합니다. OpenAI 보고서에는 20개 이상의 ChatGPT 생성 사이버 공격이 기록되어 있습니다.

AI가 가치보다 문제가 더 많다는 징후가 하나 있다면, 오픈AI 20건 이상의 사이버 공격이 발생했으며 모두 ChatGPT를 통해 발생했음을 확인합니다. 보고서는 생성 AI가 피싱 공격 수행, 악성 코드 디버깅 및 개발, 기타 악의적인 활동 수행에 사용되었음을 확인했습니다.

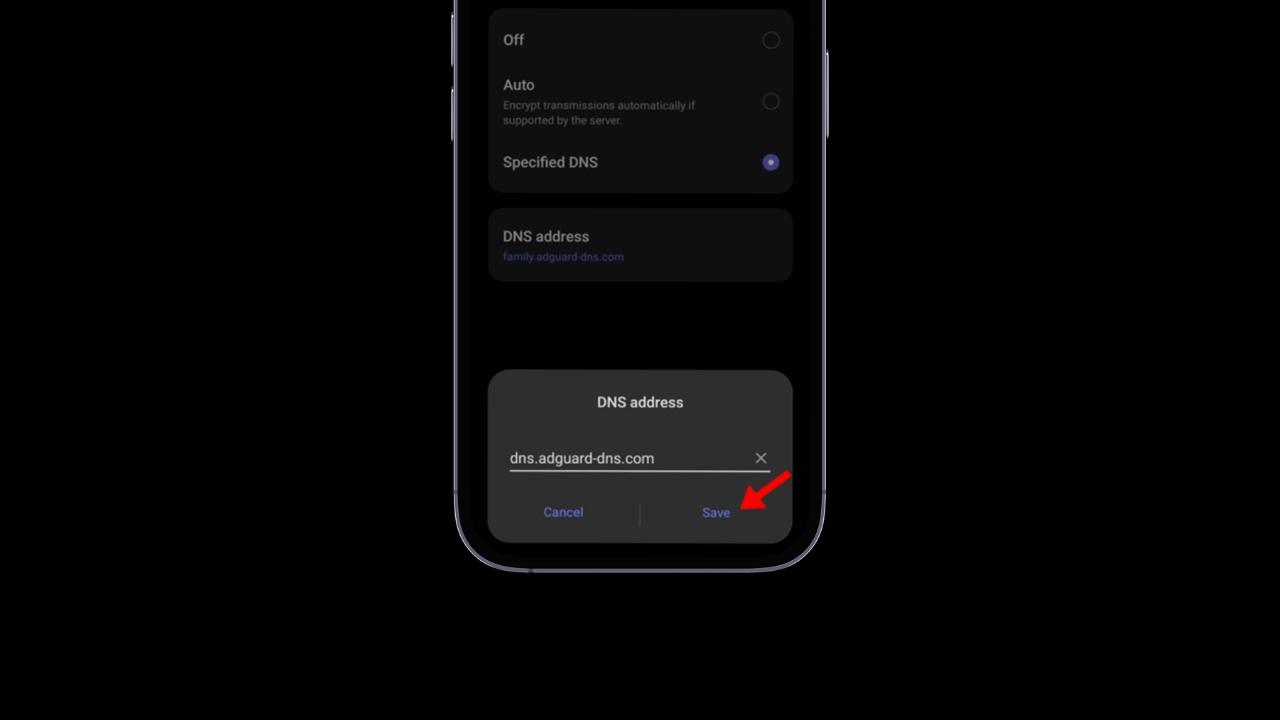

보고서는 ChatGPT 생성 AI를 사용한 두 건의 사이버 공격을 확인했습니다. 첫 번째는 2024년 11월 Cisco Talos가 보고한 것으로, 아시아 정부를 표적으로 삼는 중국 위협 행위자들이 사용했습니다. 이번 공격은 다음과 같은 방법을 사용했습니다. 피싱 'SweetSpecter'라고 불리는 이 파일에는 다운로드하여 열면 사용자 시스템에 감염 체인을 생성하는 악성 파일이 포함된 ZIP 아카이브가 포함되어 있습니다. OpenAI는 ChatGPT를 사용하여 스크립트를 개발하고 LLM 도구를 사용하여 취약점을 발견하는 여러 계정을 사용하여 SweetSpecter가 생성되었음을 발견했습니다.

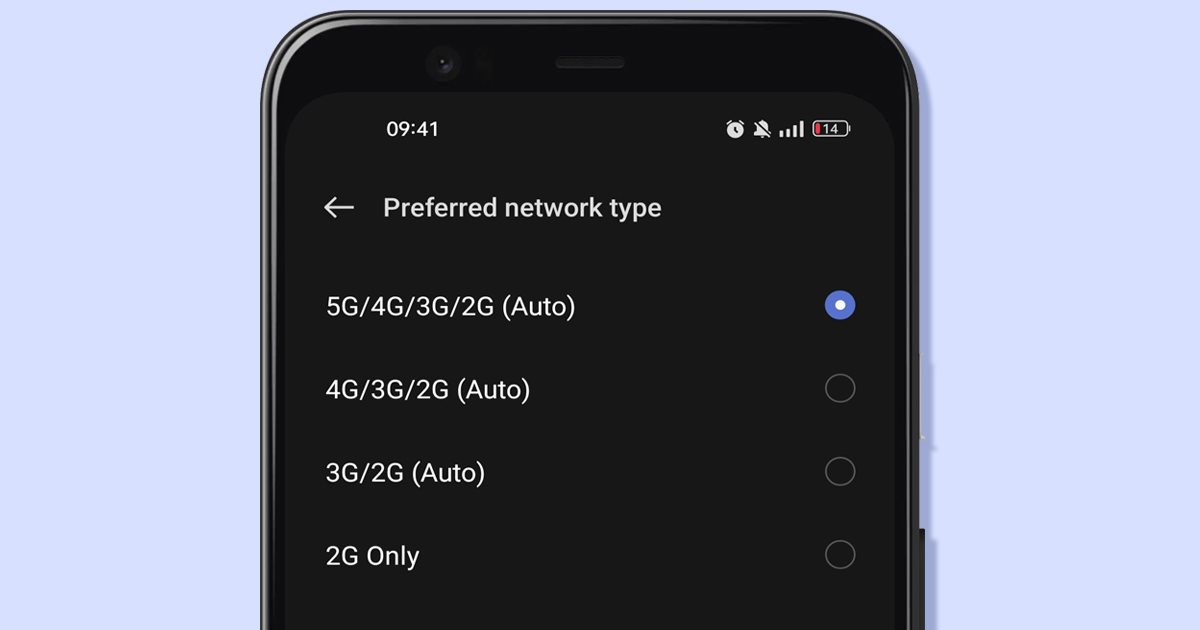

AI로 강화된 두 번째 사이버 공격은 ChatGPT를 사용하여 취약점을 악용하고 PC 사용자의 비밀번호를 훔치는 'CyberAv3ngers'라는 이란 기반 그룹에서 발생했습니다. macOS. Storm-0817이라는 이란 기반의 또 다른 그룹이 주도한 세 번째 공격은 ChatGPT를 사용하여 다음과 같은 악성 코드를 개발했습니다. 기계적 인조 인간. 이 악성코드는 연락처 목록을 훔치고 통화 기록과 전화 기록을 추출했습니다. 브라우저, 장치의 정확한 위치를 파악하고 감염된 장치의 파일에 액세스했습니다.

이러한 공격은 모두 기존의 방법을 사용하여 개발되었습니다. 악성코드 보고서에 따르면 ChatGPT가 실질적으로 새로운 악성 코드를 생성했다는 징후는 없습니다. 그럼에도 불구하고 이는 위협 행위자가 사용자를 속이는 것이 얼마나 쉬운지 보여줍니다. 서비스 악성 공격 도구를 만드는 생성 AI. 이는 필요한 지식만 있다면 누구나 ChatGPT를 활성화하여 악의적인 의도를 가지고 무언가를 할 수 있다는 것을 증명하면서 새로운 문제를 야기했습니다. 연구자들이 있는 반면 보안 이러한 잠재적인 취약성을 발견하고 보고하고 패치를 적용하려면 생성적 AI의 구현상 한계에 대한 논의가 필요합니다.

이제부터 OpenAI는 지속적인 개선을 위해 최선을 다하고 있습니다. 인공지능 시스템의 보안과 무결성을 손상시킬 수 있는 방법이 사용되는 것을 방지하는 것을 목표로 합니다. 이번 결정은 고객을 보호하기 위해 사전 예방적인 접근 방식을 유지하는 것이 중요하다는 점을 강조합니다. 기술 고급의. 그 동안 OpenAI는 AI 개발에만 집중하는 것이 아니라 내부 보안 및 안전 팀과 긴밀히 협력하여 플랫폼을 보호하기 위한 효과적이고 강력한 조치가 구현되도록 할 것입니다.

회사는 자체 환경에만 초점을 맞추는 것이 아니라 업계 및 연구 커뮤니티의 다른 참여자들과 발견 및 발전을 계속 공유할 것임을 분명히 했습니다. 이러한 협력적 접근 방식은 향후 유사한 상황이 발생하지 않도록 방지하고 모든 기술 기술 사용자를 위한 보다 안전하고 신뢰할 수 있는 생태계를 조성하기 위한 것입니다. 인공지능.

이 이니셔티브는 OpenAI가 주도하고 있지만 자체 생성 AI 플랫폼을 보유한 다른 업계 리더들도 시스템을 손상시킬 수 있는 공격을 방지하기 위해 강력한 보호 조치를 채택하는 것이 중요합니다.

이러한 유형의 위협을 예방하는 것은 끊임없는 과제이며, 개발에 참여하는 모든 회사는 필수적입니다. 인공지능 사전 예방 조치를 구현합니다.

이러한 조치는 문제가 발생한 후 이를 해결하는 데 초점을 둘 뿐만 아니라 문제가 발생하지 않도록 예상하는 데 중점을 두어야 합니다. 이러한 방식으로 기업은 모든 사용자에게 안전하고 신뢰할 수 있는 경험을 보장하고 서비스에 대한 신뢰를 강화할 수 있습니다. 기술 인공지능과 그것이 사회를 변화시킬 수 있는 잠재력에 대해 알아보겠습니다.