Отчет OpenAI: Кибератаки китайских и иранских хакеров используют ChatGPT для вредоносного ПО и фишинга.

Китайские и иранские хакеры используют инструменты ChatGPT и LLM для разработки вредоносных программ и фишинговых атак: в отчете OpenAI зафиксировано более 20 кибератак, сгенерированных ChatGPT

Если и есть хоть один признак того, что ИИ приносит больше проблем, чем пользы, то это ОпенАИ подтверждает, что произошло более двадцати кибератак, и все они были созданы через ChatGPT. В отчете подтверждается, что генеративный ИИ использовался для проведения фишинговых атак, отладки и разработки вредоносного ПО, а также для выполнения других вредоносных действий.

В отчете подтверждаются две кибератаки с использованием генеративного искусственного интеллекта ChatGPT. О первом сообщила компания Cisco Talos в ноябре 2024 года, которая использовалась китайскими злоумышленниками, нацеленными на правительства стран Азии. В этой атаке использовался метод фишинг Вредоносное ПО под названием «SweetSpecter» содержит ZIP-архив с вредоносным файлом, который при загрузке и открытии создаёт цепочку заражения в системе пользователя. OpenAI обнаружила, что SweetSpecter был создан с использованием нескольких учётных записей, которые использовали ChatGPT для разработки скриптов и обнаружения уязвимостей с помощью инструмента LLM.

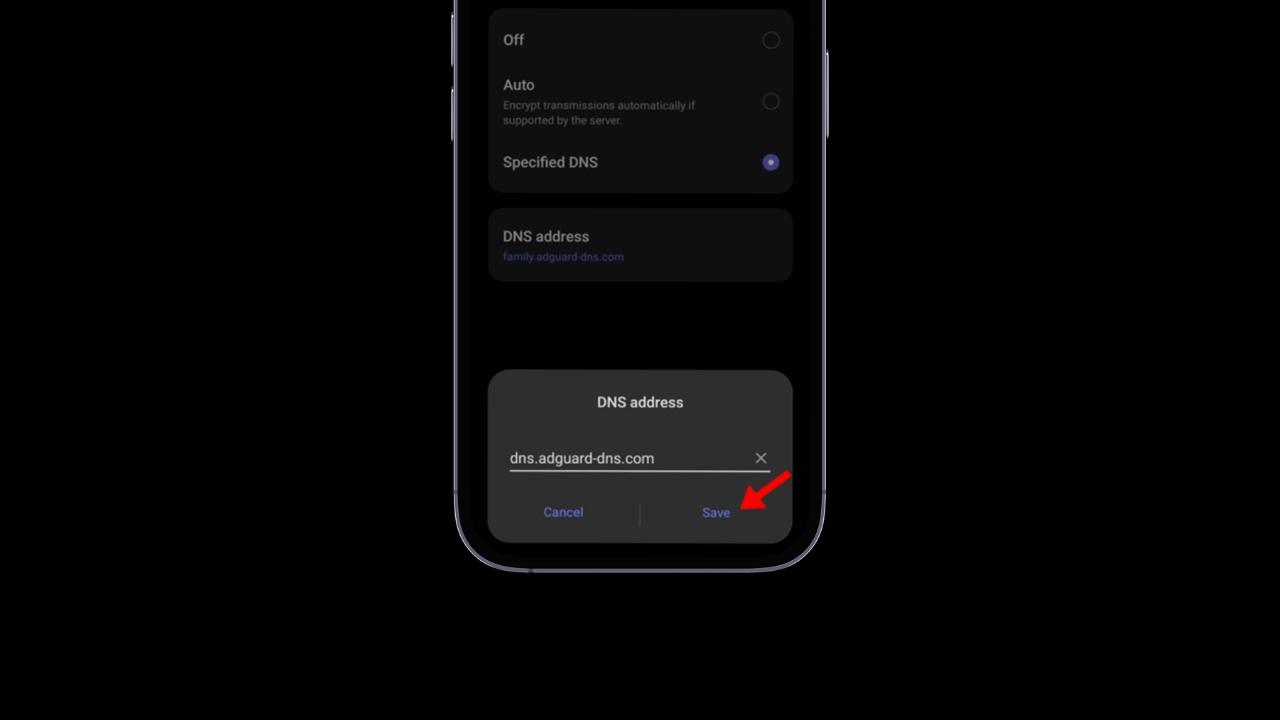

Вторая кибератака с использованием искусственного интеллекта была осуществлена иранской группой под названием «CyberAv3ngers», которая использовала ChatGPT для эксплуатации уязвимостей и кражи паролей у пользователей ПК на основе macOS. Третья атака, организованная другой иранской группировкой под названием Storm-0817, использовала ChatGPT для разработки вредоносного ПО для Android. Вредоносная программа похитила списки контактов, извлекла журналы вызовов и историю звонков. браузер, получил точное местоположение устройства и получил доступ к файлам на зараженных устройствах.

Во всех этих атаках использовались существующие методы разработки вредоносное ПО и, согласно отчету, не было никаких признаков того, что ChatGPT создал существенно новое вредоносное ПО. Тем не менее, это показывает, насколько легко злоумышленникам обмануть пользователей. услуги Генеративный ИИ для создания вредоносных инструментов атак. Это открывает новую банку с червями, доказывая, что любому человеку, обладающему необходимыми знаниями, проще активировать ChatGPT для совершения злонамеренных действий. Хотя есть исследователи безопасность Обнаружение таких потенциальных уязвимостей для сообщения о них и их исправления, а также подобные атаки создают необходимость обсуждения ограничений реализации генеративного ИИ.

Отныне OpenAI твердо намерена продолжать совершенствовать свою искусственный интеллект с целью предотвращения использования методов, которые могут поставить под угрозу безопасность и целостность их систем. Это решение подчеркивает важность сохранения упреждающего подхода к защите ваших технологии передовой. Тем временем OpenAI не только сосредоточится на разработке своего искусственного интеллекта, но также будет тесно сотрудничать со своими внутренними командами по безопасности и обеспечению безопасности, чтобы обеспечить внедрение эффективных и надежных мер для защиты своих платформ.

Компания ясно дала понять, что она не только сосредоточится на своей собственной среде, но также продолжит делиться своими открытиями и достижениями с другими игроками отрасли и исследовательским сообществом. Этот совместный подход направлен на предотвращение повторения подобных ситуаций в будущем, создавая более безопасную и надежную экосистему для всех пользователей технологических технологий. искусственный интеллект.

Хотя эту инициативу возглавляет OpenAI, крайне важно, чтобы другие лидеры отрасли со своими собственными платформами генеративного искусственного интеллекта также приняли надежные меры защиты для предотвращения атак, которые могут поставить под угрозу их системы.

Предотвращение подобных угроз является постоянной задачей, и крайне важно, чтобы все компании, участвующие в разработке искусственный интеллект внедрять упреждающие меры безопасности.

Эти меры должны быть сосредоточены не только на решении проблем после их возникновения, но и на их прогнозировании, чтобы в первую очередь предотвратить их возникновение. Таким образом, компании смогут гарантировать безопасный и надежный опыт для всех своих пользователей, укрепляя доверие к технологии искусственного интеллекта и его преобразующего потенциала в обществе.