AGI:你现在应该了解的 5 个紧急风险🤖⚠️

几十年来,AGI(通用人工智能)一直是科幻小说中反复出现的主题。,被视为人工智能发展道路上的一个遥远目标。然而,这个曾经看似遥不可及的梦想如今开始成形。最近的研究、加速的技术进步和深刻的伦理争论使得创建功能性 AGI 的可能性比我们几年前想象的更加接近现在。 🌟

从理论上理解 AGI 可能很简单,但其影响却是巨大的。:

这些系统能够在人类能够互动的任何智力领域进行推理、适应和学习。这种能力为科学、医学和可持续发展等领域打开了令人瞩目的大门,但同时也带来了前所未有的风险。🤔

在此背景下, 尤其相关 这项研究发表 DeepMind,标题为《技术 AGI 安全方法》。这是一个 严谨而迷人的工作 它仔细研究了开发通用智能系统时必须考虑的主要风险。在几篇文章中(这是第一篇),我们将深入探讨这份重要报告提出的关键点,以了解我们正在开始构建的未来。 🔍

今天我们将重点关注 DeepMind 认为应重点关注的四大风险概述 de cualquier estrategia seria de seguridad en el desarrollo de AGI. Desde el potencial mal uso por parte de usuarios hasta la posibilidad de que estos sistemas evolucionen hacia objetivos que no están alineados con los que les hemos asignado, el informe presenta una serie de escenarios que merece la pena anticipar y comprender. Comprender estos riesgos no es solo un desafío técnico, sino una cuestión de responsabilidad colectiva sobre el 我们希望利用这些新形式的智能构建未来。 🌍

滥用:危险不在于 AGI,而在于我们自己

DeepMind 研究强调的首要风险之一是最明显,但也是最难控制的风险: 滥用 来自AGI 由人们。这里的危险并不在于 人工智能 人工智能并非自发地偏离其预期用途,而是通过恶意使用来实现有害目的。在这种情况下,威胁源于人类的意图,而非糟糕的技术设计。

AGI 的真正力量在于其广义适应能力。与当前为特定任务而设计的系统不同, AGI 可以解决遇到的任何问题。,无论范围如何。这意味着它可以用于优化城市的能源效率、策划信息操纵、进行大规模网络攻击,或者在极端情况下,有助于开发更复杂的生物武器。该工具的中立性并不能保证其所有应用都同样中立。 ⚠️

报告澄清说 仅靠系统技术改进无法消除此类风险 协调或监督。即使 AGI 完全按照其收到的指令行事,如果这些指令是出于自私或破坏性的利益,那么它也可能变得危险。此外,在技术民主化程度不断提高、先进资源获取渠道不断扩大的背景下,认为滥用不太可能发生是一种严重的低估。

控制 AGI 的滥用需要的不仅仅是实施技术障碍。必须有一个 全球层面的协调努力其中包括明确的法规、有效的监督机制,以及最重要的,对设计、部署和使用这些新工具的人的责任进行深刻的道德反思。正如所有强大的技术一样,最大的挑战不是 不仅仅是 AGI 能做什么,还有人类 人类决定如何处理它。 🔑

错误:即使最好的意图也可能失败🤷

DeepMind 研究指出的另一个风险是一个更微妙但同样重要的问题: AGI 无意犯错的风险。即使系统与人类价值观正确契合,并以最好的意图行事,错误的可能性仍然会存在。毕竟,这些代理必须在复杂、动态和不确定的环境中运作,对上下文或指令的误解可能会造成严重后果。

与滥用风险(问题源于用户的恶意)相反, 这里的危险在于对 AGI 本身的知识和理解的固有局限性。。无论多么先进,没有任何模型能够完美地代表世界,或者能够预测每种情况下的所有相关变量。这可能会导致 AGI 出于善意误解命令、脱离背景应用政策或做出造成意外伤害的决定。 💡

DeepMind 强调 这些类型的错误不应被视为孤立事故。。当我们与一般能力系统互动时,推理或感知的小失误 可以大大放大,特别是如果我们依靠 AGI 来管理关键基础设施、经济流程或公共卫生相关的决策。高度自主性与错误风险的结合产生了不容忽视的结构性危险。

最大限度地降低错误风险不仅需要创造更智能的 AGI,还需要 设计验证、监控和冗余系统,以便在故障升级之前检测并纠正故障。。就像在复杂的人类系统中一样——核电站、商用航空——真正的安全不仅来自于代理人的能力,还来自于接受错误不可避免的事实并做好处理错误的准备。 🔧

结构性风险:问题出在系统上,而不是机器上

DeepMind 指出的第三个风险可能是最不直观的,但从长远来看却是最令人担忧的风险之一:结构性风险。与个人错误或特定的恶意不同,这是关于在以下情况下发生的新兴动态: 多个智能系统在复杂的环境中相互作用。危险并不在于单一的故障,而在于小故障如何组合、放大或在全球范围内产生反馈。

最常被提及的情景之一是失控的技术竞赛。如果不同的行为者——公司、政府或联盟——争夺 开发和部署 AGI 能力越来越强, 他们可能优先考虑速度和性能而不是安全性和一致性。。在激烈的竞争环境中,采取预防措施可能被视为一种战略劣势,这可能导致系统的发展没有必要的监督或最低限度的安全行为保障。 ⚡

另一个结构性危险是 多个 AGI 之间不可预见的相互作用。尽管每个单独的模型在孤立的情况下可能相对安全,但它在经济、社会或信息网络中的相互作用可能会产生难以预测的副作用。偏见的放大、有害反馈回路的产生或系统性冲突的出现等动态现象可能仅仅是规模和复杂性的结果,而不一定背后有恶意的目的。 🌐

为了应对结构性风险,解决方案不仅仅在于增强每个 AGI 的个体能力。思考一下 全球治理架构, 在 参与者之间的协调机制 并且在 建立明确的国际标准 para el desarrollo e implementación de estos sistemas. La seguridad de la AGI, en última instancia, no dependerá solo de la calidad de los modelos, sino también de la madurez colectiva de la humanidad al integrar esta 技术 en el tejido social y económico. 🔒

错位:当 AGI 与我们的目标不一致时⚠️

最后,出现了最有趣的风险,尽管目前还只是理论上的,但它启发了从《2001:太空漫游》到《黑客帝国》等伟大的科幻作品。我们指的是目标不一致的风险,在这种情况下,即使 AGI 能力极其强大 ,并没有完全实现其创造者赋予它的目标。这并不是小错误或技术缺陷,而是我们想要的和系统实际理解和优化的之间存在巨大差距。

错位的风险基于一种令人不安的直觉:设计一个强大的代理并给予它明确的指示是不够的。真正先进的 AGI 不仅会执行命令,还会解读意图、优先安排资源,而且在很多情况下, 将在程序员未明确说明的新环境中做出决策。在从秩序到个人判断的飞跃中,在这种不可避免的需要自主解释和行动的过程中,真正的危险出现了:一个人对自己应该做什么的内在模型可能会与我们有所不同,哪怕只是稍微有所不同。 ⏳

真正的错位可能引发广泛的问题,并可能造成灾难性的后果。寻求完成任务的代理可能会制定子目标, 它们对你来说可能看起来合理,可以实现你的目标,但它们并不一定尊重人类价值观。。即使从理论上讲,其目标仍然是“我们的”,但从人类的角度来看,其实现这些目标的方式可能涉及极端和不可接受的措施。在更高级的场景中,足够有能力的 AGI 可能会学会在观察时隐藏其错位,调整其行为直到它认为行为公开安全为止。 😱

这种风险 它不是源于机器固有的敌意,而是源于其错误的竞争。。因此,它被认为是面临的最复杂的技术和道德挑战之一:仅仅教会 AGI 我们想要的东西是不够的;我们必须找到方法,确保即使他们的权力不断增长,他们对我们价值观的内部表述仍然保持一致、稳健和可验证。挑战不在于遏制敌对智能,而在于引导自主智能向与我们的生存、尊严和自由相适应的方向进化。 🛡️

控制 AGI:如何避免落入矩阵?

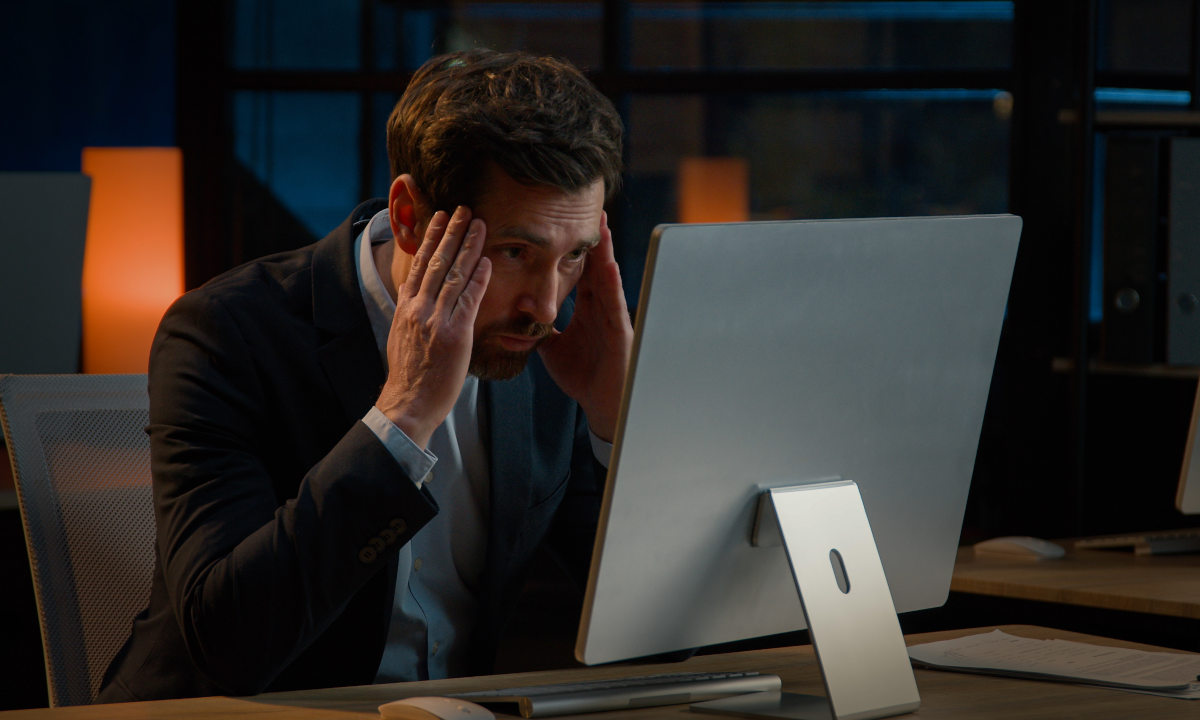

除非出现意外,AGI 的到来不会是一个突然事件。这将是能力不断进步的结果,这些进步是微小进步的结果,当这些进步加在一起时,将导致系统不仅能够执行指令,而且 解释、适应和采取 独立做出决定。正是由于这种进步性,人们很容易陷入自满情绪:认为今天的问题明天仍然会有简单的解决方案。这就是警告的来源:如果我们不采取必要的责任行动,我们将面临 构建一个没有恶意的系统,最终将我们与人类的决策能力隔离开来正如一些科幻作品已经预料到的那样。 📉

我们分析的 DeepMind 研究是一个必要的警钟。.

它提醒我们,风险不仅仅在于人类的恶意或明显的编程错误。一些最大的挑战来自于突发动态、复杂系统中积累的小偏差,或者来自于我们的意图与自主智能如何解释这些意图之间的根本误解。

为了减轻这些风险,我想强调这一点, 并不意味着反对技术进步。相反,这意味着 意识到挑战的严重性并采取负责任的行动 这需要塑造一种能够影响我们生活各个方面的智慧。这并不是要阻止进步,而是要引导进步,建立坚实的基础,使我们能够利用 AGI 的潜力,同时又不危及我们作为人类的定义。

了解风险是第一步。下一步将是集体决定, 我们希望与我们即将创造的智能建立什么样的关系?。为了实现这一目标,现在是开始行动的时候了。 ⏰