AMD stellt die branchenweit erste Ultra-Ethernet-fähige Netzwerkkarte für AI und HPC vor.

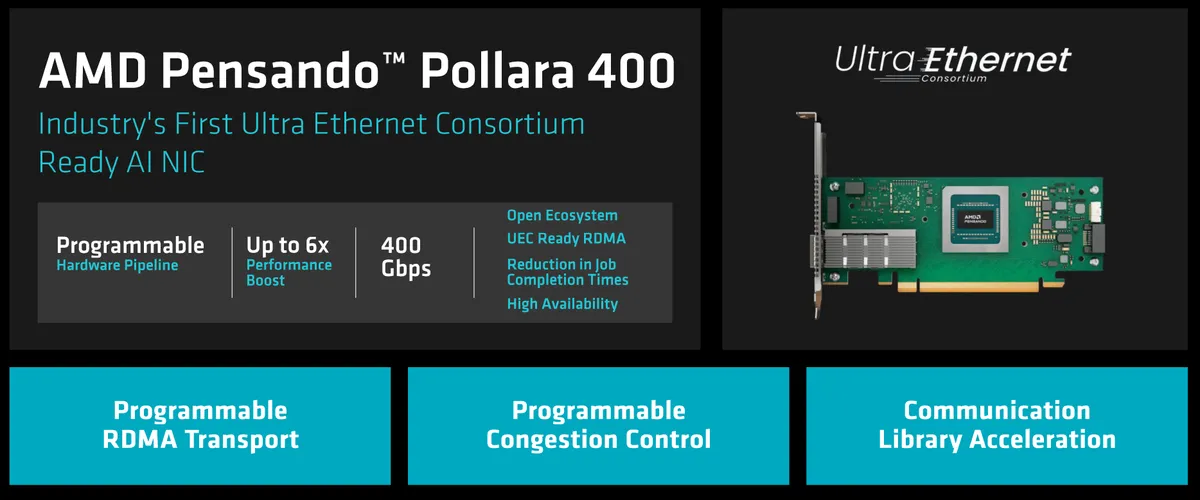

Das Ultra Ethernet Consortium (UEC) hat die Veröffentlichung der Version 1.0 der Spezifikation von Q3 2024 auf Q1 2025 verschoben, aber es scheint so AMD ist bereit zur Ankündigung eine echte Netzwerkschnittstellenkarte für KI-Rechenzentren, die für den Einsatz in Ultra-Ethernet-Rechenzentren bereit ist. Bei der neuen Einheit handelt es sich um den AMD Pensando Pollara 400, der eine bis zu sechsfache Leistungssteigerung für KI-Workloads verspricht.

Die AMD Pensando Pollara 400 ist eine 400-GbE-Ultra-Ethernet-Karte, die auf einem Prozessor basiert, der von der Pensando-Einheit des Unternehmens entwickelt wurde. Der Netzwerkprozessor verfügt über eine programmierbare Hardware-Pipeline, einen programmierbaren RDMA-Transport, eine programmierbare Überlastungskontrolle und eine Beschleunigung der Kommunikationsbibliothek. Der NIC wird im vierten Quartal getestet und im ersten Halbjahr 2025, direkt nach dem Konsortium, kommerziell verfügbar sein Ultra Ethernet die UEC 1.0-Spezifikation offiziell veröffentlichen.

Die AMD Pensando Pollara 400 AI NIC ist für konzipiert optimieren KI- und HPC-Netzwerke durch mehrere erweiterte Funktionen. Eines seiner Hauptmerkmale ist intelligentes Multipathing, das Datenpakete dynamisch auf optimale Pfade verteilt und so eine Netzwerküberlastung vermeidet. Rot und Verbesserung der Gesamteffizienz. Die NIC umfasst auch Kontrolle Routenbasierte Stauüberwachung, die Daten von vorübergehend überlasteten Routen umleitet, um einen kontinuierlichen Hochgeschwindigkeitsdatenfluss sicherzustellen.

(Bildnachweis: AMD)

(Bildnachweis: AMD)

Pollara 400 ist eine Innovation Lösung, die ein schnelles Failover bietetDadurch können Netzwerkausfälle sehr schnell und effektiv erkannt und verhindert werden. Dadurch wird sichergestellt, dass die Kommunikation zwischen den Grafikprozessoren (GPUs) unterbrechungsfrei bleibt, was für Anwendungen, die hohe Anforderungen stellen, von entscheidender Bedeutung ist Leistung und kontinuierliche Verfügbarkeit. Durch die Gewährleistung einer nahtlosen GPU-zu-GPU-Kommunikation bietet Pollara 400 eine robuste Leistung, optimiert gleichzeitig die Nutzung von Clustern künstlicher Intelligenz (KI) und minimiert Latenzzeiten, die sich negativ auf die Leistung auswirken könnten. Strafverfolgung von Daten.

Diese erweiterten Funktionen des Pollara 400 sind besonders vielversprechend, da sie das Potenzial haben, die Skalierbarkeit und Zuverlässigkeit der KI-Infrastruktur deutlich zu verbessern. Dies macht die Lösung ideal für groß angelegte Bereitstellungen, bei denen Effizienz und Kontinuität der Service Sie sind von größter Bedeutung.

Parallel dazu spiegelt das Wachstum des Ultra Ethernet Consortium das Interesse und die Expansion an der Entwicklung wider Technologien fortgeschrittene Vernetzung. Mit 97 Mitgliedern, einem deutlichen Anstieg gegenüber 55 im März 2024, arbeitet das Konsortium an der UEC 1.0-Spezifikation. Diese Spezifikation zielt darauf ab, die zu skalieren Technologie Ethernet, das in Bezug auf Leistung und Funktionen allgegenwärtig ist, um den Anforderungen von Arbeitslasten im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC) gerecht zu werden.

Die neue UEC 1.0-Spezifikation wird von der Wiederverwendung möglichst vieler davon profitieren Technologie Ursprüngliches Ethernet. Dies sichert nicht nur die Rentabilität der Entwicklung und Implementierung neuer Technologien, sondern gewährleistet auch die Interoperabilität mit bestehenden Infrastrukturen, was für eine reibungslose Markteinführung von entscheidender Bedeutung ist.

Darüber hinaus wird die UEC 1.0-Spezifikation differenzierte Profile für KI und HPC enthalten. Obwohl diese Arten von Arbeitsbelastungen einige Gemeinsamkeiten aufweisen, weisen sie auch erhebliche Unterschiede in ihren Anforderungen und Merkmalen auf. Um die Effizienz jedes einzelnen Protokolls zu maximieren, werden daher separate Protokolle entwickelt, die speziell auf die besonderen Anforderungen von KI und HPC zugeschnitten sind. Dies wird es Unternehmen ermöglichen, das Beste aus ihren Technologieinfrastrukturen herauszuholen, die Leistung zu optimieren und dies sicherzustellen Lösungen eignen sich für ein breites Anwendungsspektrum und Szenarien.