OpenAI レポート: 中国とイランのハッカーがマルウェアとフィッシングに ChatGPT を利用

中国とイランのハッカーは、ChatGPT と LLM ツールを使用してマルウェアとフィッシング攻撃を開発:OpenAI レポートには、ChatGPT によって生成された 20 を超えるサイバー攻撃が記載されています

AI がその価値よりも問題のほうが多いという兆候があるとすれば、それは OpenAI 20 件を超えるサイバー攻撃が発生し、すべて ChatGPT を通じて作成されたことが確認されています。この報告書は、生成 AI がフィッシング攻撃、マルウェアのデバッグと開発、その他の悪意のある活動の実行に使用されたことを確認しています。

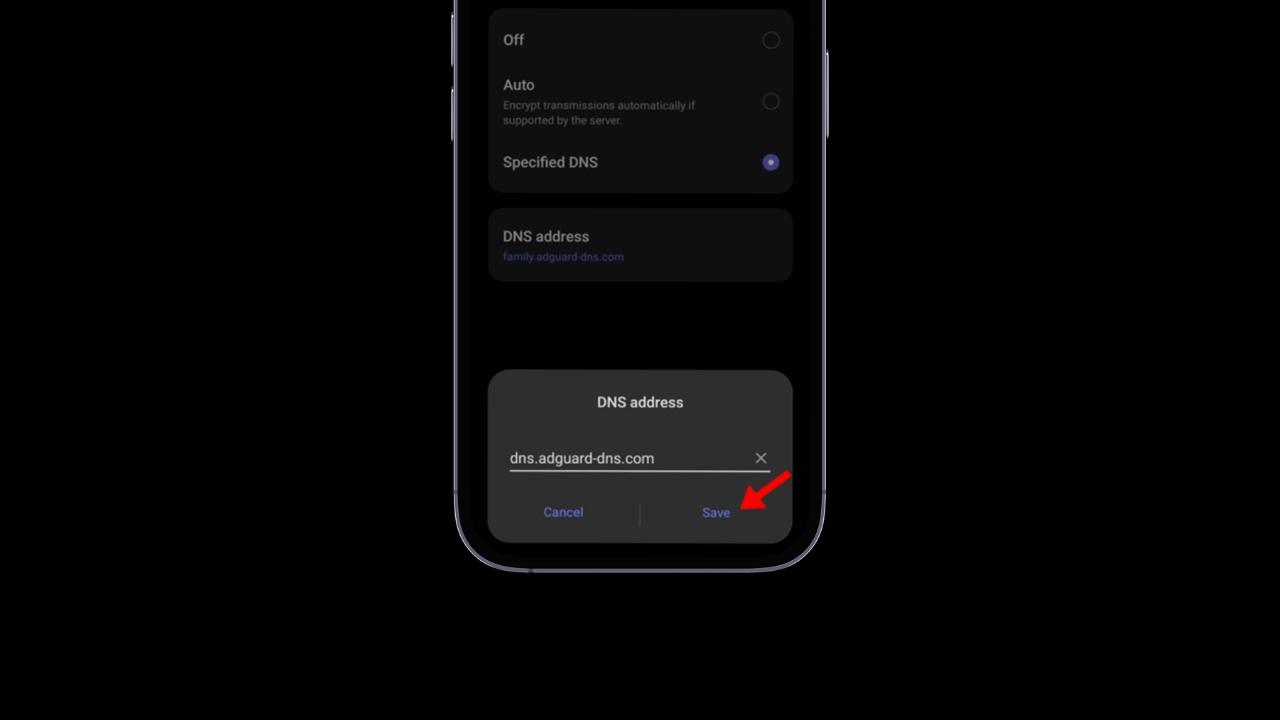

この報告書では、ChatGPT 生成 AI を使用した 2 件のサイバー攻撃が確認されています。 1 つ目は 2024 年 11 月に Cisco Talos によって報告され、アジア政府をターゲットとする中国の脅威アクターによって使用されました。この攻撃では、次のような手法が使用されました。 フィッシング llamado ‘SweetSpecter', que incluye un archivo ZIP con un archivo malicioso que, si se descarga y se abre, crearía una cadena de infección en el sistema del usuario. OpenAI descubrió que SweetSpecter se creó utilizando varias cuentas que usaban ChatGPT para desarrollar scripts y descubrir vulnerabilidades utilizando una herramienta LLM.

El segundo ciberataque mejorado con IA provino de un grupo con sede en Irán llamado ‘CyberAv3ngers' que utilizó ChatGPT para explotar vulnerabilidades y robar contraseñas de usuarios de PC basadas en macOS。 3 回目の攻撃は、Storm-0817 と呼ばれるイランを拠点とする別のグループが主導し、ChatGPT を使用してマルウェアを開発しました。 アンドロイド。このマルウェアは連絡先リストを盗み、通話記録や電話履歴を抽出しました。 ブラウザ、デバイスの正確な位置を取得し、感染したデバイス上のファイルにアクセスしました。

これらの攻撃はすべて、既存の手法を使用して開発されました。 マルウェア そして報告書によれば、ChatGPT が実質的に新しいマルウェアを作成したという兆候はありません。それでも、このことは、脅威アクターがユーザーを騙すことがいかに簡単であるかを示しています。 サービス 悪意のある攻撃ツールを作成するための生成 AI。これは新たな問題を引き起こし、ChatGPT を有効にして悪意を持って何かを行うのに必要な知識を持つ人なら誰でも簡単にできることを実証しています。研究者の中には 安全 このような潜在的な脆弱性を発見して報告し、修正する以外に、このような攻撃により、生成 AI の実装の制限について議論する必要が生じます。

今後、OpenAI はその改善を継続することに強く取り組んでいきます。 人工知能 システムのセキュリティと完全性を損なう可能性のある方法の使用を防ぐことを目的としています。この決定は、お客様の安全を守るために積極的なアプローチを維持することの重要性を強調しています。 テクノロジー 高度な。それまでの間、OpenAI は AI の開発に注力するだけでなく、社内のセキュリティおよび安全チームと緊密に連携して、プラットフォームを保護するための効果的かつ堅牢な対策が確実に実行されるようにします。

同社は、自社の環境に注力するだけでなく、その発見や進歩を業界の他のプレーヤーや研究コミュニティと共有し続けることを明らかにしました。この協力的なアプローチは、将来同様の状況が発生するのを防ぎ、テクノロジーのすべてのユーザーにとってより安全で信頼性の高いエコシステムを育成することを目指しています。 人工知能.

この取り組みは OpenAI によって主導されていますが、独自の生成 AI プラットフォームを持つ他の業界リーダーも、自社のシステムを侵害する可能性のある攻撃を防ぐために堅牢な保護措置を採用することが重要です。

この種の脅威を防ぐことは継続的な課題であり、セキュリティの開発に携わるすべての企業が次のような取り組みを行うことが不可欠です。 人工知能 予防的な保護措置を導入します。

これらの対策は、問題が発生してから解決することだけに重点を置くのではなく、問題を事前に予測して発生を防ぐことに重点を置く必要があります。このようにして、企業はすべてのユーザーに安全で信頼できるエクスペリエンスを保証し、サービスに対する信頼を強化できるようになります。 テクノロジー 人工知能と社会におけるその変革の可能性について。